世界之声网 4 月 24 日消息,在 WWDC24 召开之前,苹果公司在 Hugging Face 平台上公开了一款名为 OpenELM 的“高效语言模型”,该模型拥有开源的训练与推理框架。

这款语言模型完全开源,它的源代码、预训练模型权重以及训练方案都可以从苹果的 Github 仓库中轻松获取。

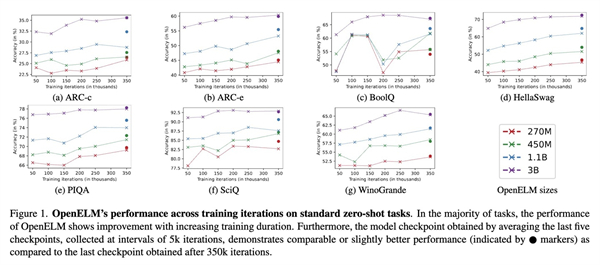

OpenELM 采用了分层缩放策略,能够有效地管理 Transformer 模型各层的参数分配,进而提升模型的准确率。举例来说,当模型参数量达到约10亿时,OpenELM 相较于 OLMo,其准确率有了2.36%的提升,而所需的预训练 tokens 数量仅为原先的 1/2。